작년에 Google I/O Extended Seoul을 후로 이런 컨퍼런스는 처음이다. 여러 컴퍼런스들이 올라올 때 마다 가고싶었지만 같이 갈 사람도 없고 그동안 바쁘다는 이유로 가지 못했다.(사실 같이 갈 사람이 없어서… T_T)

하지만 이번엔 혼자이더라도 가보자! 라는 독한 마음을 품고 회사에 휴가도 내고 가버렸다.

1일차

등록을 하면 에코백과 티셔츠 등 다양한 선물들을 나눠줬다.(역시 오길 잘했어!)

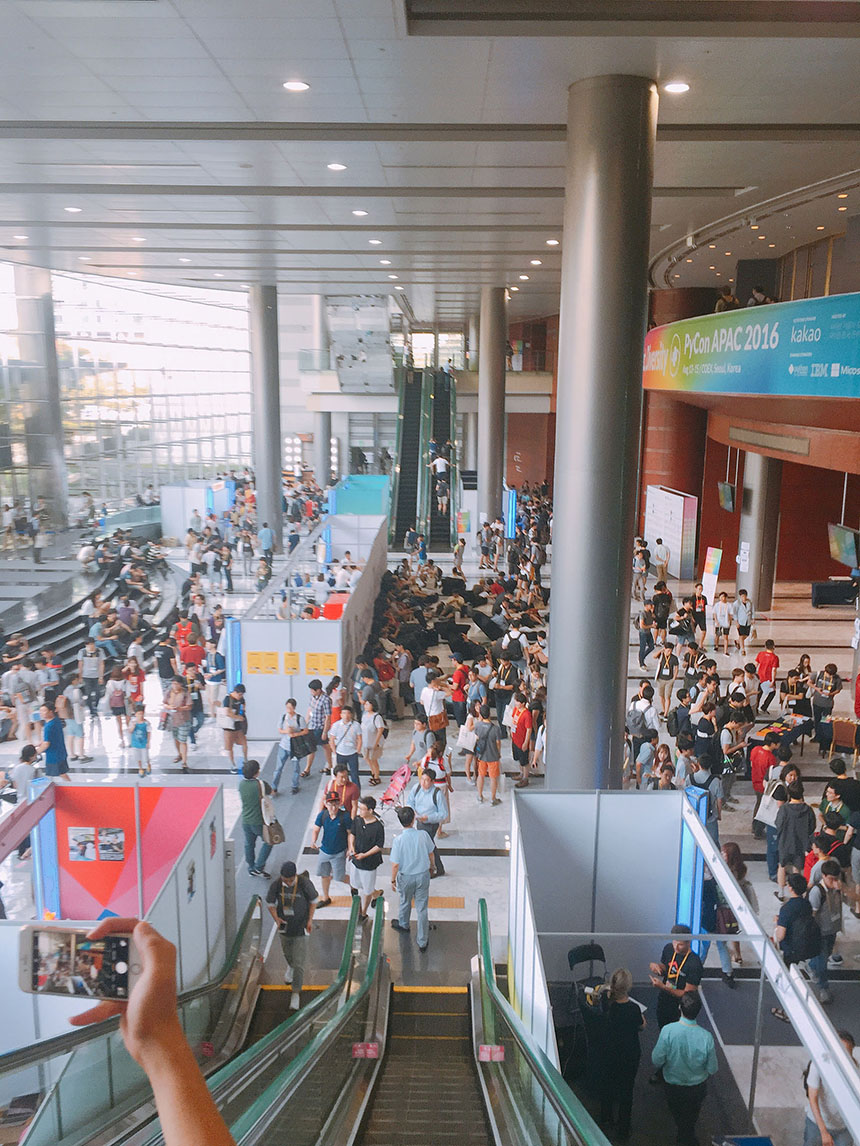

조금 빨리 도착해서 아직은 사람들이 많지는 않았지만 각종 부스에는 사람들이 꽉 차있었다.

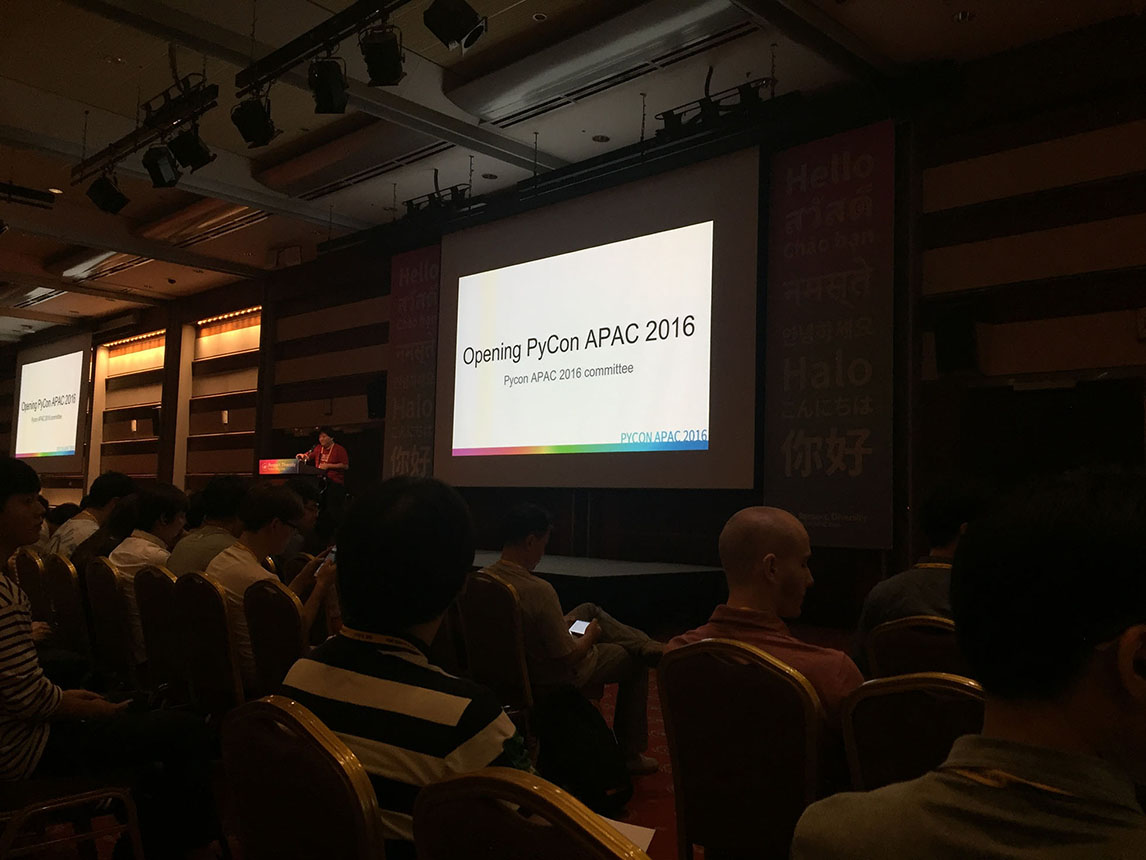

그리고 시작된 오프닝!

오프닝 후에는 pandas 라이브러리를 만든 Wes McKinney라는 분의 키노트가 시작되었는데 당연히 영어로 하셨고, 나는 (당연히 못 알아들었다고 한다.)통역기의 힘을 빌려 다행히도 알아들을 수 있었다.

그 분의 말로는 자신이 금융관련 일을 하다가 업무 처리 속도가 너무 느린것이 불편해서 파이썬을 접하고 pandas라는 라이브러리를 만들게 되었다고 한다.

엄청 멋있었다. 내가 불편해서 만들었는데 여러 사람들이 써준다니…

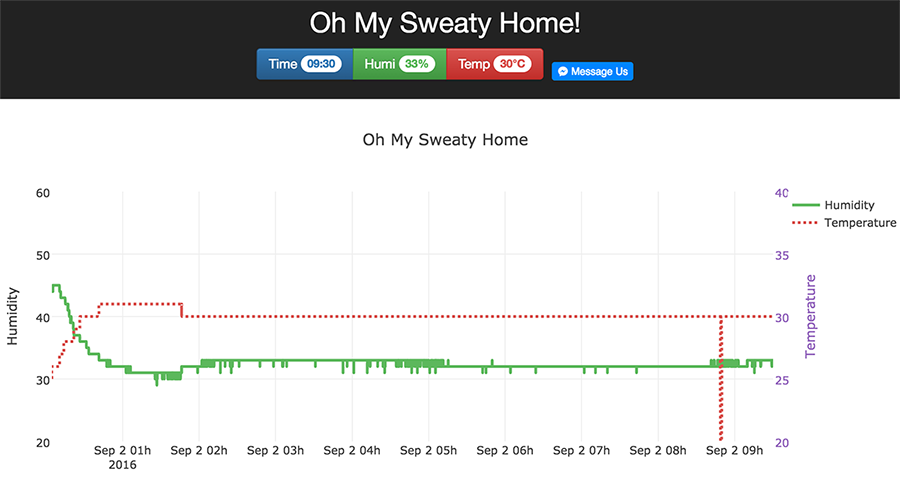

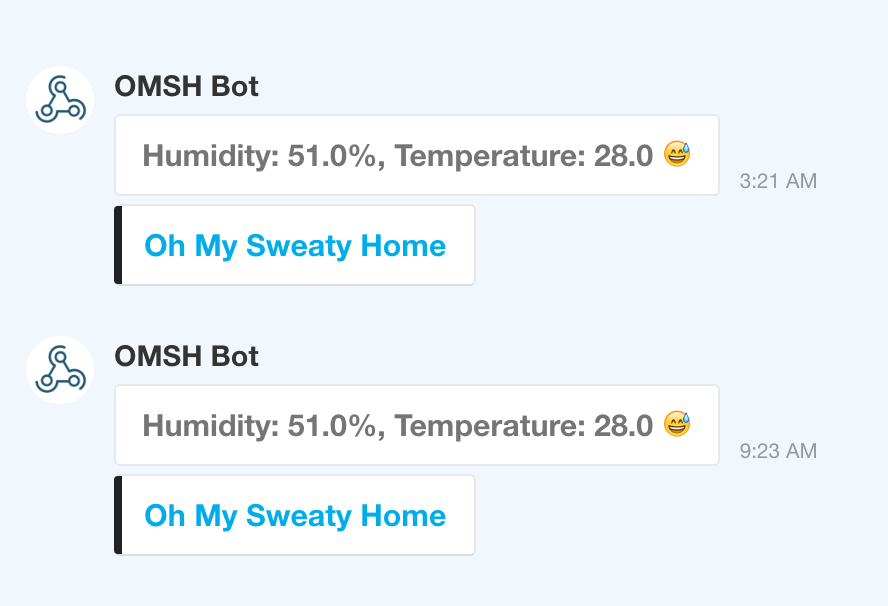

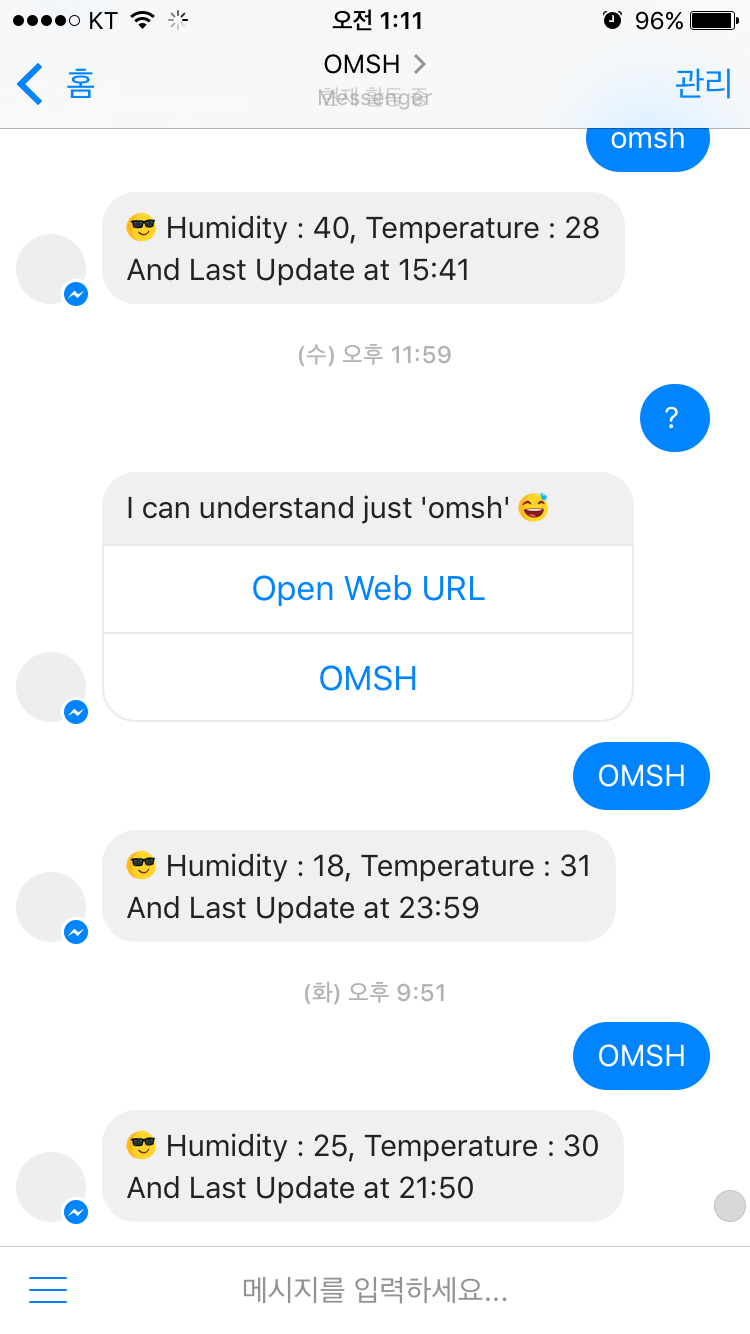

나도 요즘 집이 너무 습해서 개인프로젝트로 온습도 모니터링 시스템을 개발하고 있는데 Wes McKinney와 내 모습이 약간 오버랩 되면서 나 자신한테도 약간 뿌듯했다.

첫번째 키노트를 듣고 나니 넘나 빨리 일어난 탓에 피로가 몰려왔다. 아침에 받은 커피교환권을 쓰러 갔는데 이미 줄이 엄청나게 길어져 있었다. 두번째 키노트는 과감히 생락하고 잠도 깰겸 부스들을 돌아다녀 보기로 했다.

파이콘에 온 사람들은 한번씩 찍었다는 이름 벽

여러가지 부스들이 있었는데 그 중 제트브레인 부스에는 사람이 줄어들지 않았다. 아마도 파이참 라이센스를 준다고 사람들이 그렇게 서있는것 같았다. 사람들이 하길래 나도 했는데 정확히 뭘 주는지는 아직도 잘 모르겠다.(혹시 아는 사람은 댓글좀…)

그리고 여러 부스들을 돌아다녔는데 다들 SNS에 공유하면 기념품을 준다길래 덥석 해버렸다.

스마트스터디 부스

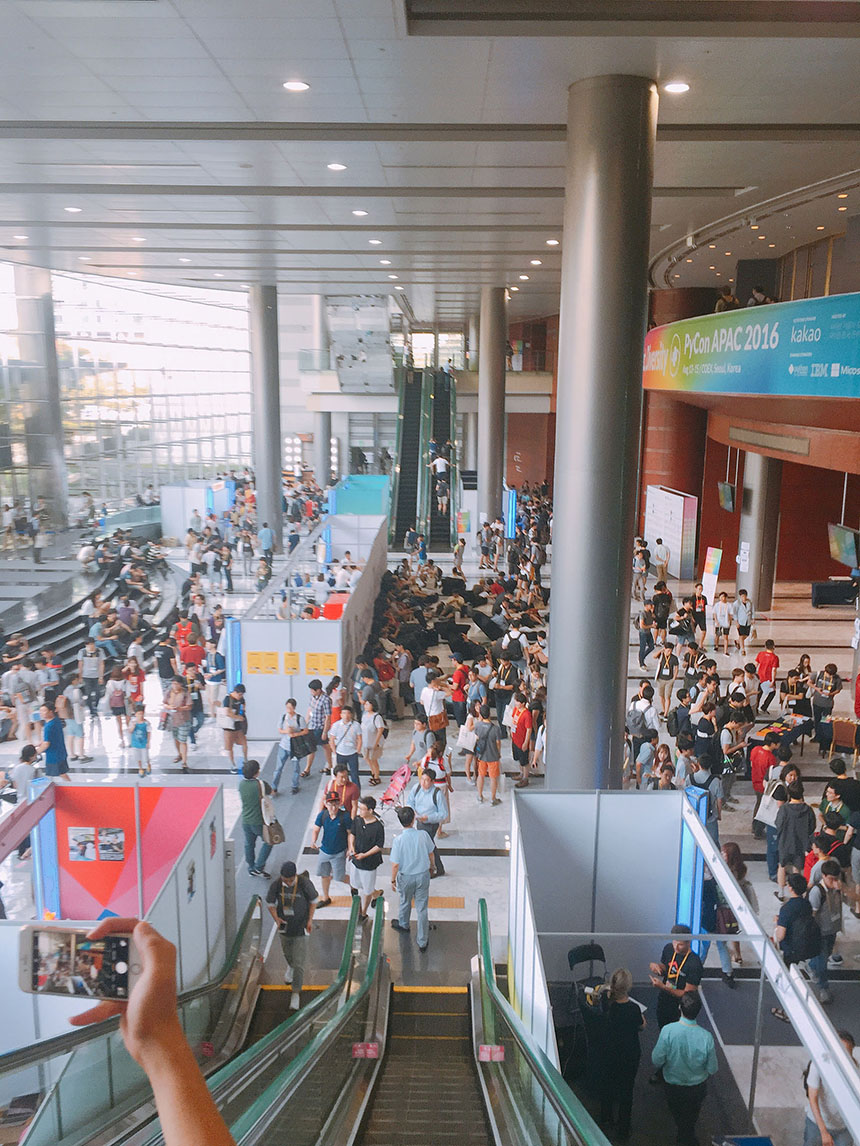

그리고 혼밥으로 점심을 간단히 떼우고 나니 사람들이 이렇게나 많아졌다. 분주하게 부스들을 돌아다니며 기념품들을 받는 사람들도 있고, 빈백에 누워 쉬거나 코딩을 하는 사람들도 많고 다양한 사람들과 네트워킹 하는 사람들도 더러 있었다.

들었던 세션들

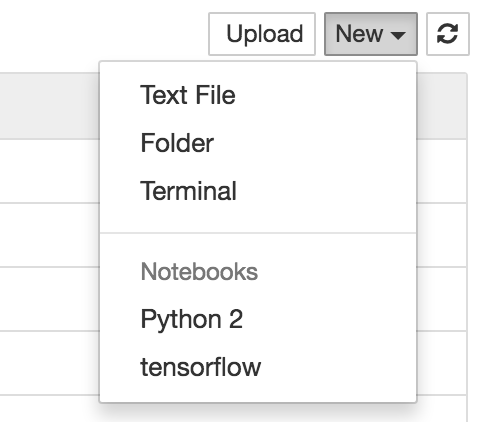

Deep Learning with Python & TensorFlow

엄청나게 기대했던 세션인데 그냥 텐서플로우랑 파이썬이랑 잘 되니까 한번써보세요. 이런 느낌이었다. 영어 세션이라 통역기를 들고갔는데 고장난 통역기를 들고와서 거의 못들었다. ㅠ.ㅠ

Creating AI chat bot with Python 3 and TensorFlow

꿀잼 세션이었다. 챗봇을 구현하는 과정들을 간단히 개념적으로 설명해줬는데 설명도 잘해줬다. 무엇보다 그분이 챗봇을 만들게 된 동기가 넘나 감동적이었다.

“First with the head, then with the heart.” -Bryce Courtenay’s The Power of once

뉴스를 재미있게 만드는 방법; 뉴스잼

파이썬으로 데이터를 수집하고 분석하고 전달하는 방법들을 알려줬다. 크롤링이나 형태소 분석기를 사용하는 등 여러가지 유용한 것들이 많았다.

Daily Continuous Deployment를 위한 custom CLI 개발 및 AWS Elastic Beanstalk에 적용하기

이것도 정말 유용했다. 우와 AWS를 이렇게도 쓰는구나… 감탄이었다. 나중에 꼭 다시 찾아볼것 같아서 슬라이드를 북마크 해뒀다.

라이트닝 토크

라이트닝 토크도 듣고 싶었는데 약속이 있어서… ㅠㅠ

2일차

지각이다. 어제 파이콘을 듣고 집에 와서 막 이것저것 하다보니 늦게 자버렸다. 그리고 늦잠을 잤다. 코엑스에 도착하니 오전 일정은 다 끝나있었다.

그런데 오픈 스페이스 토크에 9XD모임이 있길래 거기로 발걸음을 옮겼다.(너로 정했다!)

9XD

저번 모임을 신청했었는데 정원 초과로 참여하지 못했던 모임이다. 갑자기 모인 것 치고는 많은 사람들이 모여서 놀랬다. 모인 사람들과 점심을 먹고 자기소개를 하다보니 세션시간이 다 되어서 흩어지게 되었지만 짧은 시간에나마 사람들과 네트워킹을 한것이 참 좋았다.

스마트스터디

오늘도 부스에 갔다. 어젠 안주던 기념품을 주길래 또 한번 나의 SNS를 팔았다. 내 인스타에는 사진이 4개 올라가 있는데 그 중 2개가 스마트스터디에서 찍은 것이다.(스마트스터디 사랑해요❤️)

2일차 세션

Django vs Flask, 까봅시다!

9XD 모임이 끝나고 부랴부랴 내려가서 들은 세션이다. 처음에 들어갔는데 스피커분이 되게 어려보인다… 라고만 생각했는데 홈페이지에서 보고 깜짝 놀랐다. 선린인터넷 고등학교 학생인 김도현님이 이번 세션 스피커였다. 고등학생인데도 불구하고 여러 프로젝트를 하고 이런 컨퍼런스에서 발표도 한다는 사실에 참 미묘한 감정이 들면서 동기부여도 되던 세션이었다.

클라우드 상에서 Selenium을 이용한 Django 기능 테스트 자동화

이 세션의 주제는 내가 저번에 삽질한 경험이 있던 세션이라 들어봤다. 끝내 포기하고 다른 방법으로 했지만 세션을 듣는 중간중간 무릎을 탁 치던 순간이 몇번 있었다.

파이썬 삼총사

2일차 꿀잼 세션이었다. Tox, Travis, Coveralls 삼총사를 다룬 세션인데, 앞으로 저 삼총사와 함께라면 나도 오픈소스 개발자가 될 수 있을것만 같았다.

라이트닝 토크

1일차에 못들어서 오늘은 끝까지 다 들었다. 그 와중에 한글코딩은 정말 대단하신분 같다.

마무리

사실 많이 아쉬움이 남는 파이콘이었다. 물론 파이콘 그 자체는 매우 훌륭했고 대단했다. 하지만 거기에 참여하는 내가 너무 소극적이었고, 다른 사람들과 네트워킹을 좀 더 잘했더라면… 이러는 아쉬움이 남는 컨퍼런스였다. 다음에 파이콘과 같은 컨퍼런스에 또 가게 된다면 네트워킹을 더 열심히 해야겠다.